最近注意到,日常与大语言模型(LLM)的频繁互动,正在潜移默化改变我和真人的沟通方式。具体来说,有两点变化非常明显。

一、回答问题时,我开始尝试直接发送“提示词”

有时候同事向我提问,我会直接把一段 prompt 发回去。就很奇怪,别人在向你提问,你又再发一个问题过去。但由于 prompt 的表述方式明显不是“对人说话”,对方一般都能快速get到我的意图。

二、我向别人提问时,变得更加的http了(开个玩笑,意思是设想当前沟通是无状态的,每次提问都描述好上下文)

这个习惯有两个来源:

1是来自被提问的体验。白天专注写代码时,经常被打断。有时收到一个问题,还得翻半天聊天记录才能理解来龙去脉。当时就在想,如果对方每次提问都能“交代历史”那得多好。

2是来自我和 LLM 的交流方式(我习惯使用“一问一答”模式,而不开启“记忆”。因为我觉得每次独立提问的答案更可控,启用记忆反而可能引入干扰)。每次向 LLM 提问时,我都会预设它不知道角色、身份、背景和目标,从而对这些信息补全。

由于向LLM提问多了,日常工作向真人提问时,也习惯了对自己的问题进行“优化”,然后最近发现自己的提问变得非常的有质量(从而促使我发分享这篇问题)

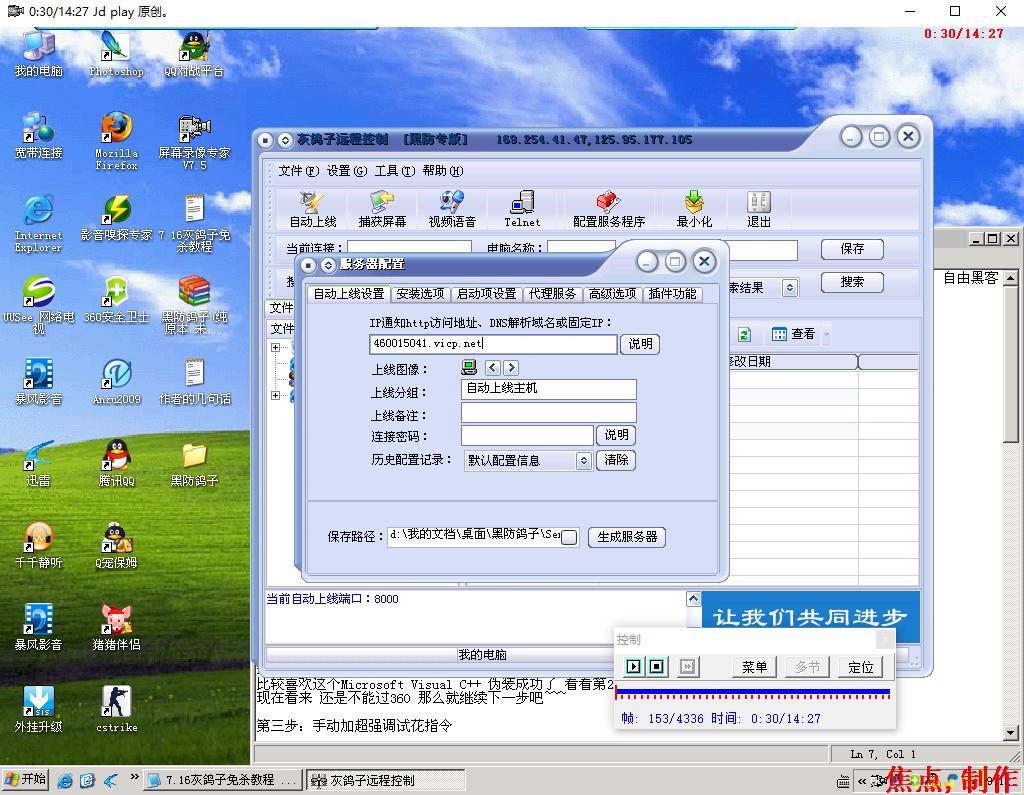

举个例子:我在使用公司内部产品时遇到一个报错。我没有直接问“这里为什么报错”,而是先截取报错界面(图片本身也是问题的一部分,除了框选重点,还要对其他位置进行模糊,这种提炼有利于对方快速识别意图),然后写道:

“我的目标是 xxx,在xx位置进行xx操作后遇到异常,请问上图中的操作是否正确或必要?如果不是,我先忽略这个异常”

交代背景后,对方除了解答当前问题,也许还会根据我的目标给出更优解