图文无关 昨天研究HashMap(版本8)底层。

0000 0000 0000 0000 0000 0000 0000 0010

0000 0000 0000 0000 0000 0000 0000 0100

0000 0000 0000 0000 0000 0000 0000 1000

0000 0000 0000 0000 0000 0000 0001 0000

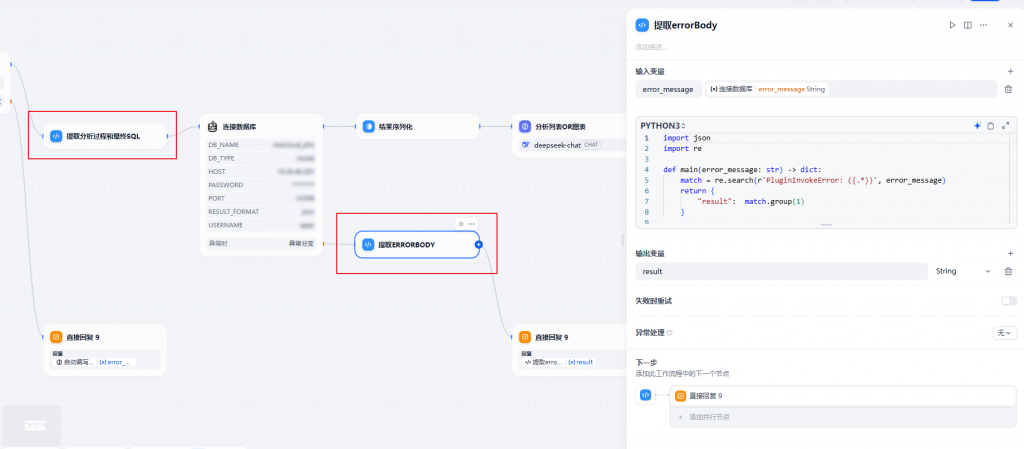

/**

* Returns a power of two size for the given target capacity.

*/

static final int tableSizeFor(int cap) {

int n = cap - 1;

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

事发在昨天晚上,今天早上自己跟自己较劲了一整个上午时间,流水账一下总结:

这样从后往前推的理解跟一开始学计算机时候理解的:“32个bit 每个bit代表1和0 所以int的取值范围是2的32次方”,丰富多了。

这过程还复习了一些很陌生的运算符:“~” 和 “>>>”

想透彻了解有点辛苦,大概就是 二进制10为什么是int的2 这样的问题。理解10变成2的话就自然懂了。

自然也不难理解 为什么int的最大值 2147483647 即二进制

回到刚才,0-1大家都知道等于-1。

计算机是对的。觉得冲突其实很简单,因为我们口头上说最大负数时候有时候会理解成那个“最左边”的数

-2147483648 + 1 = -2147483647 (1000 0000 0000 0000 0000 0000 0000 0001)

source https://blog.csdn.net/yongroot/article/details/89431136

CSDN是越来越讨厌了,大概这辈子都不会再用。。